Mặc dù Intel hiện đang chiếm đến 96% thị phần bộ xử lý dành cho trung tâm dữ liệu, thiết kế CPU truyền thống hiện nay thực chất không tối ưu cho AI. Thay vào đó việc phát triển AI phù hợp hơn với kiến trúc bộ xử lý đồ họa của Nvidia và các bộ xử lý ARM. Kết quả là trong thời gian vừa qua thì sức cầu của GPU Nvidia cho mảng AI đã tăng đến 56%. Thậm chí các ông lớn cũng có xu hướng tự phát triển bộ xử lý chuyên AI cho riêng mình, điển hình là Google với bộ xử lý Tensor phục vụ cho mảng điện toán đám mây.

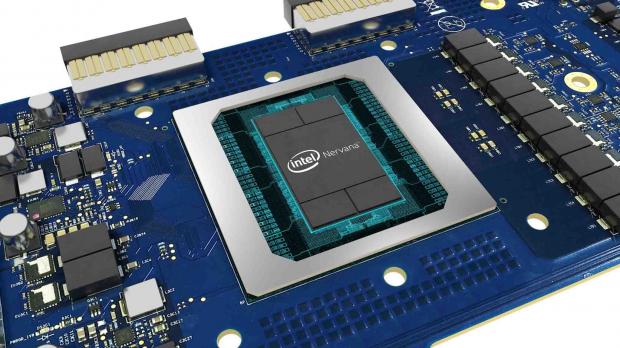

Trước bối cảnh đó, Intel đã tiến hành thu thập các nhân tài về phần cứng AI. Thế hệ bộ xử lý NNP là kết quả trực tiếp của việc Intel mua lại công ty Nervana System năm 2016, được phát triển dưới tên mã 'Lake Crest'. NNP được tối ưu để tăng tốc độ học (deep learning) của AI, ngoài ra Intel cho biết họ cũng nhận được một số lời khuyên trong thiết kế chip từ Facebook.

Một điểm khá thú vị là Intel không so sánh trực tiếp NNP với các đối thủ cạnh tranh trực tiếp, thay vào đó hãng chỉ đặt ra mục tiêu sẽ giúp AI học nhanh hơn gấp 100 lần hiện nay vào năm 2020.

Theo The Verge